导语:

AI时代已然到来,人工智能不仅是科技领域最引人瞩目的尖端技术,也在迅速改写着我们的工作与生活方式。可以说,在人工智能领域拔得头筹,才能获得全球科技竞争的入场券。如今,国内的头部科技企业,都在人工智能的赛道上加速奔跑,尤其是在中文大模型领域,已经呈现“百模争锋”的态势。

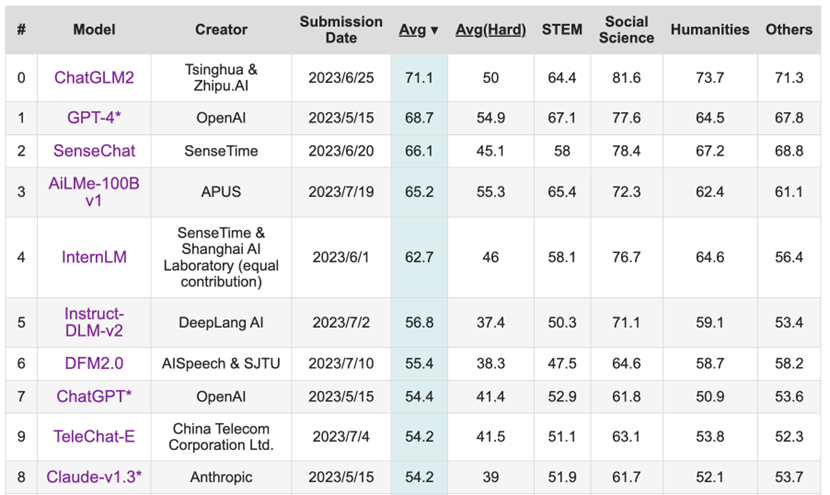

近日,C-Eval全球大模型综合性考试评测榜公布,平均分排名前三甲分别是清华智谱的ChatGLM2、OpenAI的GPT-4和商汤的SenseChat,来自APUS的AiLMe-100B v1名列第四。值得关注的是,在难题排行榜中,APUS力压群雄,位列全球榜首!

APUS全名为麒麟合盛网络技术股份有限公司,创立于2014年。

当年7月,首款工具类产品APUS Launcher上线,用户突破1000万,6个月后破亿。历经数年的研发与创新,APUS推出四大核心技术体系和八大自主技术平台,拥有200多款产品,全球用户量超24亿,覆盖200多个国家与地区。同时,APUS持有全球获授专利90余项、外观设计20余项、软件著作权200余项及商标注册280余项。2015年8月,APUS作为亚洲独角兽公司代表被《华尔街日报》评为“全球最年轻的独角兽企业”。

2018年,APUS推出CutCut、PickU、Vieka等人工智能应用,并在国际文化传播中运用,使得APUS成为国内最早布局并实践人工智能技术的科技企业之一。2023年,APUS宣布启动“大AI”战略,并发布了自研多模态大模型AiLMe。据悉,AiLMe参数已达千亿规模,具备对文本、图像、视频、音频的理解和生成能力,此次也参与了C-Eval测试,并在排行榜中名列前茅。

C-Eval是由清华大学、上海交通大学和爱丁堡大学合作构建的面向中文语言模型的综合性考试评测集,包含13948道多项选择题,涵盖52个不同学科和四个难度级别。在该评测中,APUS的AiLMe-100B v1平均分为65.2,在参与评测的大模型中排名第四。而在针对难题的评测中,AiLMe-100B v1得分为55.3分,位列第一名,险胜54.9分的OpenAI,并明显优于清华智谱和商汤的模型。

C-Eval的难题评测,即“C-Eval Hard”是国内第一个提供复杂推理问题的基准。C-Eval在整体的题库中选择了8个具有挑战性的数学、物理和化学科目,包括高等数学、离散数学、概率和统计、大学化学、大学物理、高中数学、高中化学和高中物理,形成难题测试子集。这些科目通常会涉及到复杂的LATEX方程,需要AI模型以强推理能力进行解决。因此,C-Eval Hard子集主要用来衡量模型的推理能力。据介绍,参与难题测试的模型首先需要具备数学的相关知识和逐步解题的思路,还要在解题过程中调用Wolfram Alpha、Mathematica、Matlab进行数值符号、微分和积分计算的能力,并把计算过程和结果以Latex的格式标识出来,难度非常高。

AiLMe-100B v1在C-Eval Hard测试中的优异表现,证实了APUS在人工智能领域的突破。据了解,APUS已经从AiLMe中蒸馏出文本模型“异雀八”、图像模型“异雀三”、视频模型“异雀四”、音频模型“异雀六”四个垂直领域精炼模型,并基于此创新开发出系列AI产品,打造领先的人工智能技术服务和丰富的场景应用。

热门文章

特斯拉大裁员殃及上海厂,电动车该泼冷水了

2024/4/16 14:37:02艾瑞数据 | SDN产业链及产业图谱

2024/4/30 11:39:48内容游戏的困境:成功率不高,性价比很低

2024/4/30 13:32:55艾瑞数据 | 中国共享充电宝行业市场规模

2024/4/19 10:57:49大湾区低空短途运输航线今日开通

2024/4/30 13:13:04燃油车在中国一线大城市全面溃败 二三线也岌岌可危

2024/4/28 17:44:03

扫一扫,或长按识别二维码

关注艾瑞网官方微信公众号