导语:

近日,作为多媒体领域唯一CCF A类顶级国际人工智能学术会议ACM MM 2023公布了论文接收名单,云从科技及联合研究团队的论文《All in One: Exploring Unified Vision-Language Tracking with Multi-Modal Alignment》成功入选。

All-in-One模型首次实现了视觉-语言跟踪网络结构与学习范式的大一统,摒弃了复杂的融合模块,实现了更加高效的多模态跟踪框架。All-in-One在4个富有挑战性的数据集(TNL2K, LaSOT, LaSOTExt, WebUAV-3M)上刷新了四项世界纪录,并在OTB99-L数据集上使用单模型达到了多模型效果,这是云从科技从容大模型在多模态方面的又一次技术突破。

论文简介

视觉-语言跟踪(Vision-Language Tracking)是计算机视觉和自然语言处理交叉领域一项基础而又具有挑战性的任务。该任务需要根据自然语言提示和初始边界框从视频中准确地预测目标的运动轨迹,在人机交互、视频监控、虚拟现实、自动驾驶等领域具有重要的商业应用价值。相比传统的纯视觉目标跟踪,多模态视觉-语言跟踪引入了自然语言提示,能够给用户带来更多样性的交互体验。

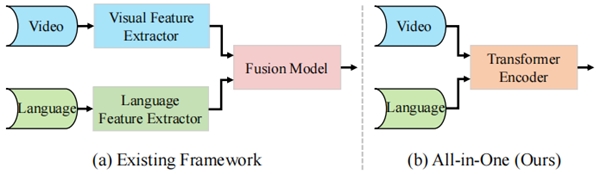

当前主流的视觉-语言跟踪框架主要包括三个模块:视觉特征提取器、语言特征提取器和融合模块。为了追求更好的性能,通常的做法是使用高度定制化和复杂的单模态特征提取器和独立的多模态融合模型。但是,这种分离特征提取和多模态融合的跟踪范式容易导致提取的特征缺乏语义指导和有限的目标感知能力。

针对这一问题,来自云从科技及联合研究团队的研究者们提出了一种视觉-语言跟踪任务的大统一模型 All-in-One,该模型只需一个统一的骨干网络即可同时提取和学习视觉、语言多模态特征。All-in-One首次实现了视觉-语言跟踪网络结构与学习范式的大一统,摒弃了复杂的融合模块,实现了更加高效的多模态跟踪框架。All-in-One在5个富有挑战性的数据集(OTB99-L, TNL2K, LaSOT, LaSOTExt, WebUAV-3M)上刷新了State-of-The-Art。

1.简介

视觉-语言跟踪(Vision-Language Tracking)是多模态大模型领域一项重要的研究课题,近期受到了工业界和学术界的广泛关注。然而过去几年的研究主要集中在双流(Two-Stream)的视觉-语言跟踪框架。该框架采用分离的视觉特征提取器和语言特征提取器,以及额外的多模态特征融合模块。早期的方法使用CNN-Transformer异构融合的框架。随着Transformer的流行,最近Transformer-Transformer同构融合的框架逐渐盛行。现有工作存在的主要问题是:使用分离的特征提取器和额外的多模态特征融合模块;难以克服多模态特征分布差异巨大的问题。

图1 All-in-One框架和现有框架对比图

为了实现统一和高效的多模态特征提取和学习,我们提出了一个统一的视觉-语言跟踪框架All-in-One,如图1所示。提出的框架的核心思想是通过一个统一的Transformer骨干网络尽可能早地建立视觉和语言信号之间的双向信息流。

提出的统一的视觉-语言跟踪框架All-in-One的优势是:1)统一的结构。简化了双流的多模态跟踪框架,实现了更加高效的多模态表征学习。2)具备成为多模态视觉-语言跟踪领域基础大模型的巨大潜力。本文提出的模型在用户定义的复杂自然语言提示下展现出了强大的泛化能力。3)简单而通用的单流(One-Stream)视觉-语言跟踪新范式。

方法

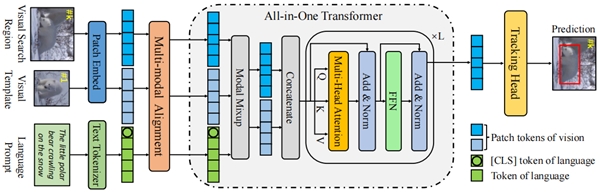

All-in-One是一个简单而有效的视觉-语言跟踪框架,其整体架构如图2所示。主要包括一个All-in-One Transformer骨干网络用于同时提取和学习多模态特征,一个多模态对齐模块用于对齐视觉和语言信号,一个跟踪头用于预测目标的位置。

图2 All-in-One的架构示意图

2.1 All-in-One Transformer。该骨干网络的输入是对齐后的原始视觉和语言信号。首先,原始的视觉和语言信号被编码为视觉tokens(搜索区域tokens、模板tokens)和语言tokens。这些tokens将被多模态对齐模块在特征空间中进行对齐,然后再传给骨干网络同时提取和建模多模态特征。统一的骨干网络能够构建视觉和语言模态之间的双向信息流,减少判别信息的丢失,提升模型感知目标的能力。

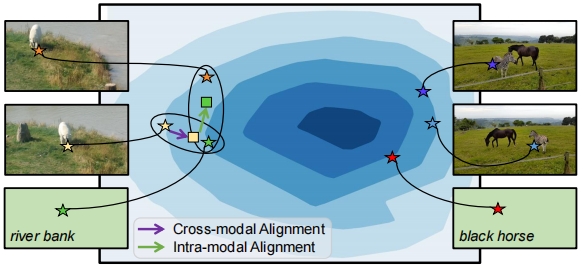

图3 MMA模块示意图

2.2 多模态对齐模块。多模态对齐模块(MMA)主要用于解决多模态特征分布差异的问题,具体如图3所示。该模块包括两个子模块:跨模态对齐子模块(CMA)和模态内对齐子模块(IMA)。CMA子模块通过拉近匹配的视觉和语言tokens在特征空间中的距离,降低多模态学习的难度。然而,仅仅进行模态间的对齐,忽略了模态内有用的监督信号。为此,我们进一步提出了IMA子模块用于学习视觉模态内部时序不变的特征。结合CMA和IMA子模块,可以学习到更加合理的多模态特征空间,促进后续的多模态提取和学习过程。

分析

为了验证大一统的视觉-语言跟踪模型All-in-One的有效性和强大的泛化能力,我们在5个公开的数据集上进行了全面的评测。

3.1 与SOTA模型的比较

本文提出的All-in-One模型在TNL2K, LaSOT, LaSOTExt, WebUAV-3M 4个数据集上取得了SOTA的结果。All-in-One只使用单模型,在OTB99-L数据集上取得了和使用多模型的VLT_TT相当的结果。这些实验结果表明单模型的All-in-One具有突出的跟踪性能和强大的泛化能力。

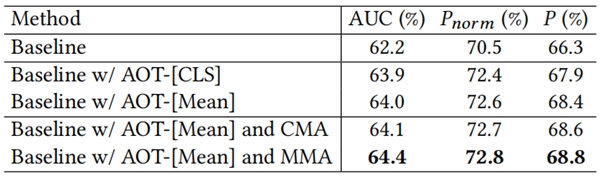

3.2 消融分析

LaSOT数据集上的消融实验表明,提出的统一的骨干网络(AOT)、模态间对齐子模块CMA和模态内对齐子模块IMA均对本文的方法有所贡献。

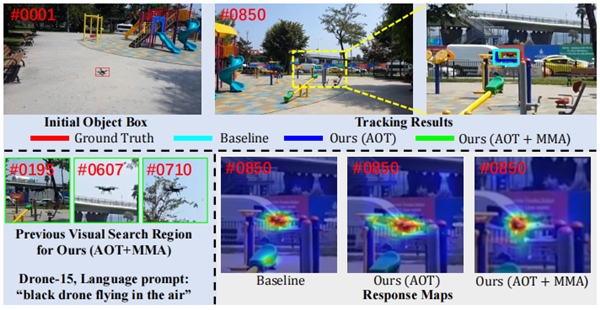

3.3 可视化结果

通过可视化跟踪的响应图,表明All-in-One模型具有强大的目标感知能力。该能力使得模型能够在复杂的背景环境下依然可以准确地跟踪目标。

3.4 定性结果

我们将All-in-One模型和三个SOTA的跟踪模型在几个具有挑战性的视频上进行了定性的比较。这些挑战性的因素包括相似干扰物、严重的视角变化、背景冗杂、外观变化、遮挡和剧烈的光照变化等。结果表明,All-in-One是一个非常鲁棒的多模态跟踪模型。

4.结论

本文提出了一个新颖的视觉-语言跟踪框架All-in-One。该框架主要包括一个统一的骨干网络和一个高效的多模态对齐模块。本文的核心思想是通过一个统一的骨干网络尽早地在对齐的多模态信号之间建立双向信息流。All-in-One Transformer实现了统一的多模态特征提取和学习。MMA模块通过模态间和模态内特征对齐进一步促进了多模态特征的学习过程。大量的实验结果表明,提出的All-in-One模型在多个数据集上取得了SOTA的结果。更重要的是,我们发现All-in-One具备成为多模态视觉-语言跟踪领域基础大模型的巨大潜力。

热门文章

特斯拉大裁员殃及上海厂,电动车该泼冷水了

2024/4/16 14:37:029亿用户、估值300亿美元,「暗黑版微信」Telegram决定上市

2024/4/7 16:53:37木头姐凯茜 · 伍德宣布投资OpenAl

2024/4/12 14:32:45艾瑞数据 | 中国共享充电宝行业市场规模

2024/4/19 10:57:49到底什么人在闲鱼上赚到钱了?

2024/4/7 18:21:49艾瑞数据 | 中国采购数字化平台潜在市场空间近7000亿元

2024/4/12 10:57:16

扫一扫,或长按识别二维码

关注艾瑞网官方微信公众号